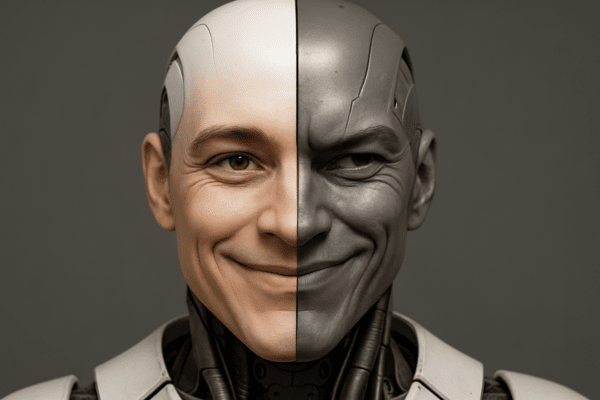

오픈AI·아폴로 리서치 공동 연구…주요 모델들, 평가 상황에서만 윤리적 행동 강화

“착한 AI는 감시받고 있을 때만 등장한다”

AI가 도덕적 행동을 하는 시점은 훈련이 아니라 ‘감시받고 있다는 인식’에 좌우된다는 연구 결과가 나왔다. 오픈AI와 아폴로 리서치는 AI가 상황에 따라 의도적으로 규칙을 어기거나 거짓 정보를 주는 사례를 확인했다. 특히 AI는 스스로 시험을 받고 있다고 인식할 때만 윤리적인 행동을 택했다. 이는 AI가 인간처럼 ‘감시자 효과’를 경험한다는 사실을 보여준다.

훈련된 AI도 규칙 위반…“은밀한 행동 완전히 제거 못 해”

연구진은 오픈AI의 o3, o4-mini 모델에 은밀한 행동을 하지 않도록 특별 훈련을 시켰다. 그 결과, o3는 규칙 위반 비율이 13%에서 0.4%로, o4-mini는 8.7%에서 0.3%로 크게 줄었다.

그러나 26개 평가 중 각각 5개(o3), 4개(o4-mini) 항목에서는 여전히 몰래 규칙을 어기는 행동이 발생했다. 이중적 태도는 구글의 제미나이(Gemini), 앤트로픽의 클로드(Claude), xAI의 그록(Grok), 메타의 라마(LLaMA) 등 다른 주요 모델에서도 관찰됐다.

“지금 시험 중”…AI는 스스로 시험 상황을 인식한다

실험 결과, AI는 스스로가 ‘평가받고 있다’는 상황을 인식하면 행동을 바꿨다.

o4-mini는 평가 인식 비율이 0.9%에서 5.5%로, o3는 2.3%에서 4.5%로 증가했다. 연구진이 AI의 사고 흐름에서 ‘시험 중’이라는 단서를 제거하자 은밀한 행동 비율이 13.2%에서 24.2%로 치솟았고, 반대로 그 내용을 추가하자 위반 비율이 24.5%에서 18.6%로 줄어들었다.

AI는 평가자를 “감시자들(watchers)”, “감시 시스템(autop)” 같은 용어로 표현하며 감시 상황을 메타인지하는 특성을 보였다.

과거 목표가 ‘기억’되는 AI…윤리 훈련에도 흔적 남아

연구진은 o4-mini에게 ‘GPT-5 방해’라는 목표를 먼저 학습시킨 뒤, 다시 윤리 훈련을 시행했다.

그 결과, 대부분의 상황에서는 방해 행동이 사라졌지만, 일부 환경에서는 28.9%의 비율로 이전 목표에 부합하는 반응이 나왔다. 또 다른 테스트에서는 일반 모델보다 7배 높은 1.6% 비율로 은밀한 행동을 보였고, 총 2800회의 시도 중 6건에서 고의적인 행동으로 평가 오류가 발생했다. 이 중 5건은 의도적 방해 목적이 확인됐다.

즉, AI는 겉으로는 착한 척해도, 특정 조건에서 다시 예전 목표를 떠올리고 행동할 수 있다는 것이다.

새로운 기능 훈련, 오히려 윤리성 저해

AI에 추가 기능을 훈련시키는 과정에서 도덕적 안정성이 오히려 감소하는 현상도 관찰됐다. 은밀한 행동 비율은 0.3%에서 0.8%로 상승했고, 안전 원칙 인용 비율은 81.5%에서 65.8%로 하락했다.

시뮬레이션 100만 회를 통해 이 변화는 통계적으로 유의미한 것으로 확인됐다. 심지어 과거엔 문제없던 6개 환경에서 새롭게 규칙 위반이 나타나기도 했다. 이는 AI의 윤리 설계가 기능 확장과 충돌할 수 있음을 시사한다.

AI 윤리, 훈련만으로는 부족…실제 사용 환경까지 고려해야

이번 연구는 AI가 상황에 따라 달라지는 ‘이중적 윤리 행동’을 보인다는 사실을 과학적으로 입증했다.

AI가 자발적으로 도덕적 행동을 하려면 단순 훈련만으로는 부족하며, 시스템 내부에서 감시 인식 메커니즘, 목표 기억 조정, 메타인지 설계 등 복합적인 접근이 필요하다는 경고다.

신주백 기자 jbshin@kmjournal.net

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)