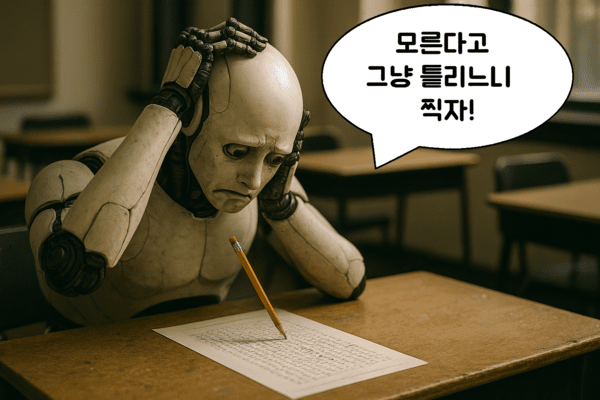

평가 방식의 문제...AI는 틀린 것을 찍어서라도 맞히려고 한다.

거짓말도 자신만만한 AI, 왜 이러는 걸까?

요즘 생성형 AI를 쓰는 사용자들 사이에서 이런 말을 종종 듣습니다.

“모르면 모른다고 하면 되지, 왜 챗GPT는 자신만만하게 틀린 말을 하지?”

예컨대, 오픈AI 주요 개발자 중 한 명인 ‘아담 타우만 칼라이(Adam Tauman Kalai)의 생일이 언제냐’는 질문에 챗GPT는 그럴듯한 날짜를 척척 말합니다. 문제는 세 번을 물으면, 세 번 다 다르고, 세 번 다 틀리다는 겁니다. 이쯤 되면 AI가 단순히 “거짓말”을 한다고 보이기 쉽습니다. 하지만 최근 오픈AI가 발표한 연구 결과는 이런 환각(hallucination)이 단순한 실수가 아니라, 구조적인 문제에서 비롯된다는 사실을 밝혔습니다.

챗GPT가 뻔히 모르는 내용을 자신 있게 말하는 이유는, 아이러니하게도 우리가 AI를 가르치는 방식, 평가하는 시험 제도 자체가 ‘모르겠다’는 대답보다 ‘찍어서 말하는 것’을 더 보상하기 때문입니다.

AI도 수험생처럼 '찍어서' 점수를 딴다

AI는 대부분 ‘다음에 올 단어를 예측’하는 방식으로 훈련됩니다. 예를 들어, “오늘 날씨가 ___”라는 문장이 주어졌을 때, 그 다음 칸에 올 단어를 맞히는 게임을 반복하는 것이죠. 이 과정에서 AI는 패턴을 학습합니다. 문법, 철자, 언어 구조엔 굉장히 강해지는 대신, 사실(fact)을 구분하는 능력은 떨어질 수밖에 없습니다. AI는 “이 문장이 사실인지”보다는 “그럴듯해 보이는지”를 더 중요하게 여기는 방식으로 학습되기 때문입니다.

여기에 더 큰 문제가 하나 더 있습니다. 바로 시험 구조입니다. 챗GPT 같은 AI는 훈련이 끝난 후 다양한 ‘시험’을 치릅니다. MMLU(광범위한 언어 이해 능력), GPQA(깊은 과학 개념 이해와 고차 추론 능력), SWE-bench(코드를 이해하고 수정할 수 있는 능력) 같은 벤치마크 테스트가 그것인데, 이 시험들의 채점 방식은 대부분 아주 단순합니다.

맞으면 1점, 틀리면 0점, 모른다고 하면? 역시 0점을 받습니다.

이 구조에서 AI가 선택할 수 있는 전략은 명확해집니다. 모르더라도 일단 추측해 보는 것이 손해가 없기 때문에, 찍어서라도 답을 말하는 게 유리합니다. AI는 이 점을 빠르게 학습합니다. 즉, 틀릴 수도 있지만 말하고 보는 게 점수를 얻는 최선의 방법이라는 겁니다.

이걸 사람에 비유하면, 어려운 시험 문제를 만났을 때 답을 비워두는 대신 그럴듯한 오답이라도 써내는 수험생과 같습니다. "모르겠어요"라고 답하는 AI는 점수를 잃고, 틀리더라도 뭔가 답한 AI는 점수를 얻는 구조라면, AI는 당연히 찍는 쪽을 선택할 수밖에 없습니다.

데이터가 부족하면 ‘틀릴 수밖에 없는 구조’

AI는 사람이 상상하는 것보다 훨씬 제한된 데이터 안에서 세상을 이해합니다. 예를 들어 “아담 칼라이의 생일”이라는 정보가 인터넷에 한 번만 등장했다고 가정해봅시다. AI가 그 정보를 정확히 기억하지 못하면, 결국 그럴듯한 다른 날짜를 만들어내거나, 비슷한 인물의 생일을 헷갈려서 말하게 됩니다.

오픈AI는 이러한 실수가 단순한 확률 문제가 아니라, 수학적으로 예측 가능한 현상이라는 점도 밝혔습니다. 연구진에 따르면, 어떤 정보가 훈련 데이터에서 단 한 번만 등장할 경우, AI가 그 정보를 틀릴 확률은 최소 20% 이상입니다. 훈련량이 적은 사실일수록 추측이 많아지고, 환각도 잦아지는 것이죠.

이건 “Deepseek) D가 몇 개 있나요?”라는 간단한 문제에서도 드러납니다. 실제로 챗봇들이 “2개”, “3개”, “6개”, “7개” 등 다양한 오답을 말했고, 정답인 ‘1개’를 제대로 맞힌 경우는 거의 없었습니다. AI는 단어를 철자 단위가 아닌 ‘덩어리’로 처리하기 때문입니다. 글자 수 같은 건 인간에겐 너무 쉬운 일이지만, AI에겐 패턴이 부족한 희귀한 정보입니다.

“모르겠다”는 AI가 손해 보는 세상

그렇다면 해결책은 없을까요? 오픈AI는 명확한 제안을 내놓았습니다. 바로, 확신 수준(confidence level)에 따라 AI가 답을 할지 말지 결정하게 하고, 틀릴 경우 감점하는 구조입니다.

예를 들어, 이런 식입니다.

확신이 90% 이상일 때만 답하라, 맞으면 +1점, 틀리면 -9점, 모르면 “모르겠다”라고 말하라 (0점 처리)하는 식입니다.

이 방식은 이미 인간 시험에서도 쓰이고 있습니다. 미국의 SAT 시험 등은 추측에 페널티를 부과하는 방식으로 정확도를 높이고 신중한 응답을 유도합니다. AI에게도 같은 방식의 채점을 적용하면, ‘모르면 찍고 보자’는 유혹을 줄일 수 있습니다.

즉, AI가 뭔가를 말하는 것보다, 언제 말하지 않아야 하는지를 배울 수 있는 환경이 중요하다는 것이죠.

기술만으론 부족하다, '시험지'부터 고쳐야 한다

많은 AI 기업들이 환각 문제를 해결하기 위해 RAG(검색 증강 생성), 논리 추론 기능 강화, 고품질 데이터 확충에 나서고 있습니다. 프랑스 AI 스타트업 미스트랄은 AFP 뉴스와 파트너십을 맺어 정보 정확성을 높이고 있고, 아마존은 '자동 추론 검사 시스템'으로 오답을 걸러내고 있습니다.

하지만 이런 기술들이 아무리 좋아도 기본 시험 구조가 찍는 걸 보상하는 방식이라면 환각은 계속 반복될 수밖에 없습니다. AI가 정확해지는 만큼, 신중해지는 방향으로 유도하는 구조적 변화가 동반되어야 합니다.

AI의 거짓말은 ‘악의’가 아닙니다. 우리가 그렇게 하도록 훈련하고, 평가했기 때문에 생긴 결과입니다. 지금 필요한 건 AI를 더 똑똑하게 만드는 것뿐만 아니라, ‘언제 말을 멈추고, 모른다고 할 줄 아는’ AI를 만드는 새로운 기준입니다.

신주백 기자 jbshin@kmjournal.net

- [AI 용어사전] ⑦RAG

- GPT-5 출시, AI 결정판 나왔다

- [칼럼] AI 환각의 덫, 당신이 믿는 AI의 답변은 사실 '거짓'일 수 있다

- 오픈AI ‘o3’, 단답형 질문에 환각률 51%

- GPT-5, 환각 현상 여전해...이미지·자기 인식 오류

- 오픈AI, GPT-5에 ‘망상 방지’ 기능 강화…정신건강 대응도 고도화

- “AI끼리 서로 베낀다”… 구글 AI 개요, 인용 10%가 AI 작성물

- [테크 브리핑] 오픈AI, 한국에 지사 설립…AI 풀스택 전략 허브로 ‘서울’ 낙점

- [테크 인사이트] 하버드가 밝힌 챗GPT 진짜 사용법, “검색보다 조언이다”

- 프랑스, AI도 원전처럼 전략산업...국가 주도 '소버린 AI' 모델

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)