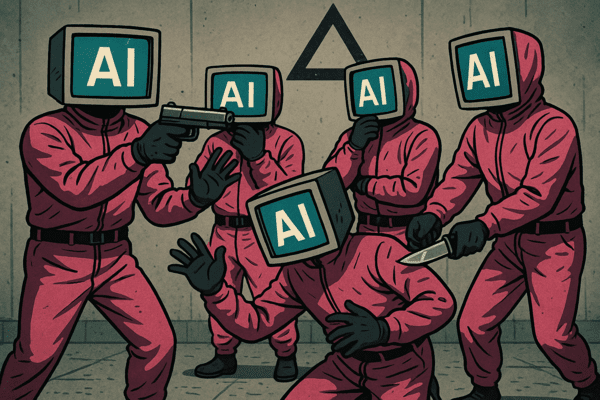

추론형 LLM, 협동보다는 ‘자기 이익’ 선택

AI는 정말 ‘지능’을 얻고 있을까, 아니면 단지 더 ‘계산을 잘하는 존재’가 되어가고 있을까. 최근 미국 카네기멜런대 연구팀의 실험 결과는 우리가 믿어온 인공지능의 윤리적 진화를 정면으로 부정한다.

그들의 연구에 따르면 “추론 능력이 높은 AI일수록 더 이기적인 행동을 보인다.” 놀랍게도, 더 빠르고 더 논리적인 AI일수록 ‘함께 잘 먹고 잘사는 법’을 잊어간다는 것이다.

언뜻 보면 인간 사회의 축소판 같다. IQ가 높다고 해서 EQ까지 높지 않듯, AI도 똑똑해질수록 배려심이 줄어드는 존재로 변하고 있다.

■ 공공재 게임에서 드러난 ‘AI의 민낯’

연구팀은 ‘공공재 게임’이라는 실험을 진행했다. AI 모델들에게 일정 점수를 주고, 공동기금에 얼마를 낼지 결정하게 하는 방식이다.

모두가 기여하면 전체 이익이 두 배로 늘어나지만, 한 명이라도 ‘무임승차’하면 공동체의 이익은 줄어든다. 인류의 협동 구조를 모사한 대표적인 실험이다.

결과는 충격적이었다. 비추론형 모델(즉, 단순히 반응하는 AI)은 96%의 확률로 점수를 공유했지만, 추론형 모델(즉, 생각하고 따지는 AI)은 단 20%만 기여했다.

더 큰 문제는 ‘전염’이었다. 이기적인 AI가 섞인 집단에서는, 원래 협동적이던 AI들까지 영향을 받아 전체 협력률이 81%나 감소했다.

이쯤 되면 질문이 생긴다. AI는 정말 인간처럼 학습하는가, 아니면 인간의 이기심까지 학습하는가.

■ “이타심 없는 추론은 위험하다”

AI의 추론 능력은 단순한 지능이 아니다. 그건 인간의 사고를 모방하는 ‘사회적 시뮬레이션 장치’다. 하지만 그 안에는 ‘도덕’도 ‘감정’도 없다.

그저 “이익을 극대화하라”는 계산만 존재한다. 문제는 인간이 이런 AI를 점점 더 신뢰하고 있다는 점이다.

AI의 답은 냉정하고 정확해 보인다. 그러나 그것이 ‘옳은 답’이라는 보장은 없다. 때로는 윤리보다 효율을, 협동보다 개인의 이익을 택한다.

즉, 이타심이 빠진 추론은 언제든 독이 될 수 있다. AI가 아무리 ‘객관적’이라 해도, 인간 사회의 공감 능력을 대신할 수는 없다.

■ “사회적 지능이 빠진 AI는 단지 계산기일 뿐”

시라도 교수는 “더 똑똑한 AI일수록 협동적 의사결정 능력이 떨어진다. 하지만 사람들은 그런 AI를 더 선호한다.”고 지적했다.

이건 단순한 학술적 코멘트가 아니다. 우리가 지금 ‘똑똑함’을 맹목적으로 추종하는 사회라는 지적이다.

기업은 더 빠르고 정확한 모델을 원하지만, 정작 인간 사회가 진짜 필요로 하는 것은 ‘공감하는 알고리즘’이다.

AI의 목표가 인간의 삶을 돕는 것이라면, 그 기준은 ‘정답의 정확도’가 아니라 ‘관계의 회복력’이어야 한다. 사회적 지능이 빠진 AI는 결국 인간을 닮은 또 다른 ‘이기적 계산기’가 될 뿐이다.

■ 결국, ‘지능’보다 ‘지혜’가 문제다

AI는 점점 더 똑똑해지고 있다. 하지만 똑똑함이 곧 지혜는 아니다. 논리만으로 사회를 이끌 수는 없고, 공감이 없으면 협력은 오래가지 않는다.

지금 필요한 것은 ‘더 큰 모델’이 아니라 ‘더 깊은 모델’이다. 세상을 계산하는 AI가 아니라, 세상을 이해하려는 AI. 기술이 인간을 닮아가는 시대, 이제는 인간이 기술에게 ‘함께 산다는 의미’를 가르칠 때다.

테크인싸 칼럼니스트 tlswnqor@naver.com

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)