긴 문맥 처리 시대, 다국어 AI의 허점 드러나다

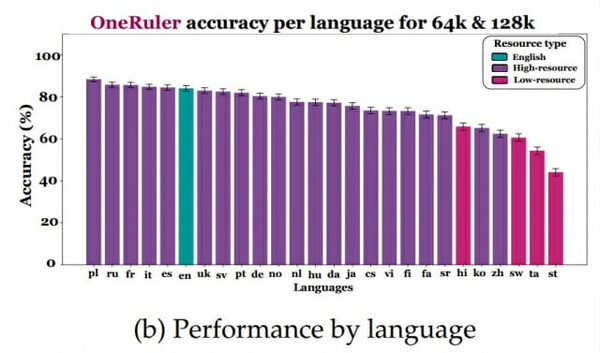

폴란드어 1위, 영어는 6위…한국어는 22위

메릴랜드대학교와 매사추세츠대학교 애머스트(UMass Amherst) 연구진이 최근 공개한 ‘원룰러(OneRuler)’ 벤치마크는 대형 언어모델(LLM)의 긴 맥락(Long Context) 처리 능력을 26개 언어로 평가한 결과를 담고 있다.

그 결과는 의외였다. 폴란드어가 평균 정확도 88%로 1위를 차지했으며, 영어는 6위, 한국어는 22위로 하위권에 머물렀다. 중국어는 23위(62.1%)로 더 낮은 성적을 기록했다.

연구팀은 “대부분의 LLM이 영어·중국어 중심으로 학습된 점을 고려하면, 폴란드어의 선전은 매우 이례적”이라며 “위키피디아 문서 수가 많고 라틴 문자를 사용하는 언어들이 상위권을 형성했다”고 밝혔다. 실제로 상위 10개 언어는 대부분 슬라브어·로망스어·게르만어 계통이었다.

맥락 길이 늘릴수록 언어 격차 3배 확대

모델의 문맥 처리 길이를 8천 토큰에서 12만 8천 토큰으로 늘리자, 상위권과 하위권의 성능 격차가 11% → 34%로 세 배 이상 확대됐다. 한국어는 위키피디아 문서 약 70만 개를 보유하고 있음에도 ‘저자원 언어’ 수준의 성능을 보였다.

연구진은 “긴 맥락 확장 훈련 데이터에서 비영어권 언어가 거의 등장하지 않기 때문”이라고 분석했다.

긴 문맥에서도 비교적 선전한 모델은 제미나이 1.5 플래시(Gemini 1.5 Flash)와 큐엔 2.5 72B(Qwen 2.5 72B) 정도였다.

“한국어 지시문 쓰면 성능 20% 하락”

또 하나 주목할 부분은 ‘지시문 언어’의 영향이다. 같은 모델이라도 지시문을 어떤 언어로 쓰느냐에 따라 결과가 달랐다.

예를 들어 영어 맥락에 한국어 지시문을 쓰면 평균 정확도가 91% → 71%(-20%)로 급락했다. 반대로 한국어 맥락에 영어 지시문을 사용하면 오히려 61% → 77%(+16%)로 향상됐다.

즉, ‘지시문은 영어로, 맥락은 현지어로’ 구성할 때 성능이 가장 안정적으로 유지됐다.

“답이 없다” 옵션 하나로 정확도 30% 급락

흥미롭게도 연구진은 NIAH(Needle in a Haystack) 과제에 “답이 존재하지 않을 수도 있다”는 선택지를 추가하는 단순한 변경을 줬을 때,

오픈AI의 o3-mini-high 모델이 12만 8천 토큰 기준 정확도 32% 하락이라는 충격적 결과를 보였다고 밝혔다.

대부분의 모델이 “답이 있음에도 없다”고 오답을 내는 경향이 강했으며, 이는 모델의 불확실성 인식 한계를 보여준다.

단어 빈도 문제는 모든 모델이 ‘전멸’

단어 빈도 추출(Common Word Extraction) 테스트에서는 모든 모델이 실패했다.

영어조차 상위 10개 단어를 맞히는 쉬운 버전에서도 31.5% 정확도에 그쳤고, 난이도가 높아지면 1% 미만으로 떨어졌다. 특히 o3-mini-high와 Deepseek-R1은 ‘출력 토큰 초과’ 오류가 빈번했다.

다국어 AI의 긴 문맥 처리, 여전히 험난

이번 원룰러 연구는 대형 언어모델이 짧은 문맥에서는 인상적인 성능을 보이지만, 긴 문맥과 비영어권 언어에서는 여전히 심각한 한계를 가진다는 점을 분명히 보여준다.

한국어, 중국어, 타밀어, 스와힐리어 등은 특히 긴 문서 처리에서 급격한 성능 저하를 보였으며, 이는 실제 비즈니스·행정 업무 환경에서 LLM을 다국어로 활용할 때의 실제적 리스크를 의미한다.

연구진은 “원룰러 벤치마크가 다국어 긴 맥락 학습의 새로운 기준이 되길 바란다”며 향후 ‘교차 언어 문맥 이해(Cross-lingual Context Understanding)’가 차세대 모델 경쟁의 핵심 과제가 될 것이라고 강조했다.

신주백 기자 jbshin@kmjournal.net

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)

![[낭만 테크 시대] AI 대항해 시대](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5603_10714_4334_1764121414_160.jpg)