감정 추정 방식으로 '40가지' 감정 인식

인공지능(AI)이 인간의 감정을 더 깊고 정교하게 이해하는 단계로 진화하고 있다. 독일 기반의 비영리 AI 연구 단체 LAION(Large-scale Artificial Intelligence Open Network)은 인텔(Intel)과의 공동 연구를 통해, 인간의 복잡한 감정을 40가지로 세분화해 분석할 수 있는 감정 인식 AI ‘EmoNet’을 발표했다.

이 기술은 인간 감정을 텍스트, 이미지, 음성 기반으로 정밀하게 추정하는 최신 모델로, 기존의 단순한 감정 분류 시스템을 한 단계 끌어올렸다는 평가를 받고 있다.

40가지 감정의 정교한 분류… 심리학 이론 기반한 모델 설계

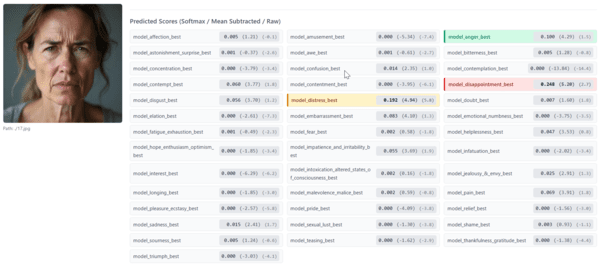

EmoNet은 감정을 단순히 분류하는 기존의 AI 방식에서 벗어나, 감정을 맥락적이고 구성적인 현상으로 인식한다. 이 시스템은 미국 심리학회의 대표적 참고서인 『Handbook of Emotions』을 기반으로 한 40가지 감정 분류 체계와 심리학자들의 자문과 검증을 통해 학습됐다.

이러한 접근법은 ‘구성된 감정 이론(Theory of Constructed Emotion)’에 바탕을 둔다. 이 이론은 하버드대 심리학자 리사 펠드먼 배럿이 제안한 것으로, 감정은 뇌가 생리적 신호, 환경적 맥락, 과거 경험 등을 조합하여 구성하는 인지적 결과물이라는 관점이다. 이에 따라 EmoNet은 ‘감정을 감지하는(detector)’ 것이 아니라, ‘감정을 추정(estimate)’하는 메커니즘을 적용한다.

이미지로 감정을 읽는 EMONET-FACE… 전문가 수준의 정확도

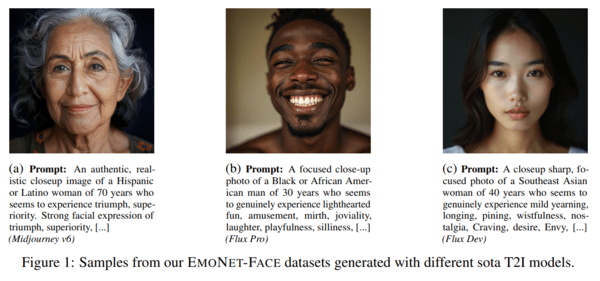

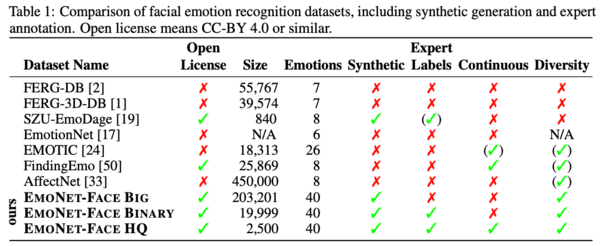

시각 기반의 감정 인식 시스템인 EMONET-FACE는 총 세 가지 데이터 리소스를 활용해 개발되었다.

BIG: 20만 장 이상의 합성 이미지를 기반으로 모델 사전 훈련 수행

BINARY: 약 2만 장 이미지와 6만 2천 건 이상의 감정 주석을 포함한 미세 조정용 데이터셋

HQ (High Quality): 심리학 학위를 보유한 전문가들이 직접 2,500장의 이미지에 대해 40개 감정을 0~7 강도로 평가한 정밀 벤치마크

특히 HQ 데이터는 전문가 간 3중 합의 시스템을 적용해 감정 분류 정확도의 신뢰성을 극대화했다. 공개된 테스트 결과에 따르면 EmoNet은 구글의 Gemini 2.5 Pro와 감정 인식 특화 AI인 Hume AI를 정확도 기준에서 상회했으며, 스피어만 상관계수 기반 평가에서 인간 주석자 수준의 성능을 기록했다.

음성 데이터를 통한 감정 추정… EMONET-VOICE의 새로운 기준

음성 기반 감정 인식 모델인 EMONET-VOICE는 11개의 서로 다른 음성을 사용하여 영어(2,156시간), 독일어(716시간), 스페인어(888시간), 프랑스어(881시간) 등 총 4개 언어, 5천 시간 분량의 오디오 데이터셋을 구축했다. 이 데이터는 LAION이 개발한 오디오 감정 연기 프로젝트 ‘LAION's Got Talent’에서 추출되었으며, 각 오디오 스니펫은 전문가 3인의 합의 평가를 통해 감정 강도가 ‘존재하지 않음’, ‘약함’, ‘강함’으로 구분된다.

이 벤치마크는 OpenAI의 GPT-4 오디오 모델과 하이퍼랩의 감정 추출 API를 활용해 정제되었으며, EmoNet은 이 기준에서도 기존 상용 모델보다 높은 일관성과 정확도를 보였다.

감정까지 전사하는 BUD-E Whisper… 오디오 분석의 새 패러다임

EmoNet 기술은 단순히 음성을 텍스트로 바꾸는 것을 넘어, 말투와 비언어적 표현까지 분석한다. 이를 위해 개발된 모델이 BUD-E Whisper다. 이 시스템은 OpenAI의 Whisper를 기반으로 재학습되었으며, 음성 데이터 내 웃음, 한숨, 헐떡임 등 비어휘적 표현을 식별할 수 있다.

또한, 화자의 성별, 연령, 말하기 스타일까지 감지하며, 텍스트에 감정 주석을 자동으로 부착하는 감정 캡션(emotion captioning) 기능을 제공한다. 이 모델은 블로그, 영화 대사, 온라인 일기 등에서 수집한 5천 시간 이상의 오디오 데이터를 학습에 활용했으며, LAION은 여기에 음성 활동 감지(VAD) 기술과 Gemini Flash 2.0을 접목시켜 감정 분류 체계에 기반한 주석 자동화를 실현했다.

오픈소스 정신으로 감정 AI 민주화 추진

EmoNet 프로젝트의 또 다른 중요한 특징은 전 구성요소가 크리에이티브 커먼즈(CC-BY 4.0) 라이선스 하에 오픈소스로 공개되었다는 점이다. 이에 따라 연구자, 기업, 개발자 누구나 해당 감정 모델을 상업적 혹은 학술적 목적으로 자유롭게 사용할 수 있으며, 이는 감정 기반 인공지능의 글로벌 표준화를 촉진할 것으로 기대된다.

감정의 기술화, 공감하는 기계의 출현

EmoNet은 단지 AI가 표정을 읽는 것이 아니라, 인간 내면의 복잡한 정서를 맥락 속에서 해석하는 능력을 갖춘 첫 번째 대규모 오픈 모델 중 하나다. 감정 기반 AI는 고객 서비스, 디지털 치료, 감성 콘텐츠 분석 등 다양한 산업에 새로운 가능성을 제공하며, 특히 인간과 AI의 정서적 상호작용이 필요한 분야에서 폭넓게 활용될 전망이다. 이제 AI는 더 이상 '기계적인 응답자'가 아니라, 감정과 맥락을 읽고 반응하는 ‘공감하는 존재’로 진화하고 있다.

신주백 기자 jbshin@kmjournal.net

※ 본 기사는 LAION 공식 블로그 및 EmoNet 논문 요약 자료(2025년 6월 발표), 『Handbook of Emotions, 4th Edition (Guilford Press)』, Lisa Feldman Barrett 교수의 감정 이론 연구를 바탕으로 작성되었습니다.

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)