AI 데이터센터에 100조 원대 투자…울산에도 40억 달러 투자 예정

아마존웹서비스(AWS)가 SK하이닉스의 고대역폭메모리(HBM) 사업에서 엔비디아(NVIDIA)에 이은 차세대 핵심 고객사로 빠르게 부상하고 있다. 업계에 따르면 AWS는 2025년까지 자체 AI 칩 ‘트레이니엄 3(Trainium 3)’에 12단 HBM3E를 채택할 가능성이 높으며, 이에 맞춰 SK하이닉스도 해당 제품의 양산 준비에 착수한 것으로 파악됐다.

100조 원 AI 인프라 투자 속 HBM 수요 급증

AWS는 글로벌 AI 데이터센터 인프라 확대에 따라 2025년 한 해에만 약 1,000억 달러(약 138조 원)를 투자할 예정이다. 이는 전년 대비 약 20% 증가한 수치로, AI용 고성능 반도체 수요 급증을 반영한 조치다.

지난 6월 14일(현지시간), AWS는 호주에 2029년까지 총 200억 호주달러(약 17조6천억 원)를 투자해 데이터센터를 신설하겠다고 발표했다. 앞서 미국 노스캐롤라이나주(100억 달러), 펜실베이니아주(200억 달러), 대만(50억 달러) 등에서도 대규모 투자 계획을 밝힌 바 있다.

국내서도 SK그룹과 협력…울산에 40억 달러 투입

AWS는 국내에서도 SK그룹과 협력해 울산 미포 국가산업단지에 총 103MW 규모의 초대형 AI 데이터센터를 구축 중이다. 2029년까지 전체 설비 가동을 목표로 하며, **AWS의 직접 투자액은 약 40억 달러(약 5조5천억 원)**에 달할 것으로 알려졌다.

이러한 글로벌 및 국내 인프라 확장은 고성능 메모리(HBM)에 대한 실수요를 구조적으로 확대시키고 있으며, 이에 따라 SK하이닉스는 HBM3E 12단 제품의 양산 시점을 앞당기는 방안을 적극 검토 중이다.

자체 AI칩 ‘트레이니엄3’…HBM3E 12단 4개 탑재 유력

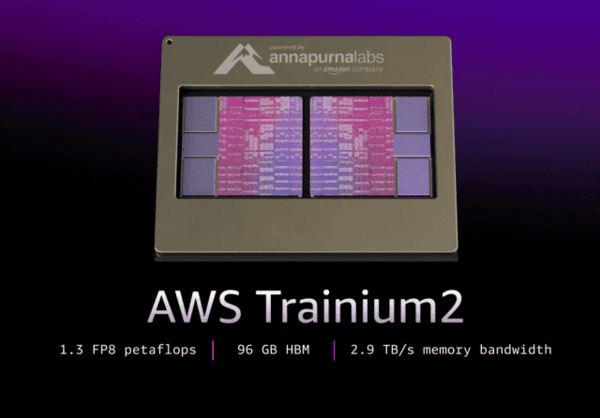

AWS는 NVIDIA의 GB200·GB300 시리즈 외에도, 자체 머신러닝(ML) 특화 AI칩인 ‘트레이니엄(Trainium)’ 시리즈를 병행 개발하고 있다. 2023년 하반기 출시된 ‘트레이니엄 2’는 HBM3 또는 HBM3E 8단 제품을 최대 96GB까지 탑재했다.

현재 업계에 따르면, 2025년 말 또는 2026년 초 출시가 예상되는 3세대 트레이니엄(Trainium 3)에는 HBM3E 12단 제품 4개를 적층한 총 144GB 메모리 구성이 적용될 전망이다. 한 반도체 업계 관계자는 “트레이니엄3는 전작 대비 연산 처리 속도는 약 2배, 전력 효율성은 40% 이상 향상될 것이며, HBM3E 12단 채택은 사실상 확정된 상태”라고 전했다.

SK하이닉스, HBM 점유율 1위 굳히기 나서

SK하이닉스는 현재 글로벌 HBM 시장에서 50% 이상의 점유율을 유지하며 선두를 달리고 있다. 특히 HBM3E 상용화 시점과 생산 안정성 측면에서 경쟁사 대비 우위를 확보하고 있다는 평가다.

업계 추산에 따르면 AWS는 2025년 NVIDIA의 GB200·GB300 전체 수요의 약 7%를 점유할 것으로 보이며, 여기에 자체 트레이니엄 시리즈 수요까지 합산할 경우 전체 HBM3E 시장의 10% 이상을 AWS가 차지할 수 있다는 분석도 나온다.

이는 SK하이닉스 입장에서도 단일 고객사 기준 최대 규모의 물량 계약으로 이어질 수 있으며, HBM3E 연간 매출 10조 원 돌파 가능성을 높이는 요인이 될 것으로 전망된다.

신주백 기자 jbshin@kmjournal.net

- SK하이닉스, 차세대 D램 ‘4F² VG’·‘3D D램’ 전면에… “향후 30년 이끌 핵심 기술 공개”

- 'HBM 강자' SK하이닉스, 1분기에 삼성 제치고 D램 점유율 1위

- SK하이닉스 경영진 실리콘밸리行…AI 인재 찾아 '글로벌 포럼'

- SK하이닉스, 세계 최고층 321단 낸드 기반 모바일용 설루션 개발

- SK하이닉스, HBM4 양산 앞두고 인공지능 뮤직비디오 공개

- 삼성전자 DTCO vs SK하이닉스 풀스택 메모리… AI 반도체 전략 격돌

- [테크 브리핑] SK하이닉스, HBM4로 반도체 왕좌에 도전…‘기술 리더’ 넘어 ‘시장 지배자’ 될 수 있을까

- “AWS 핵심 리전 멈췄다”…전 세계 서비스 마비, 한국도 덮친 클라우드 위기

- 아마존까지 ‘AI 투자 전쟁’ 합류… 17조 6천억 회사채로 자금 확보

![[동학] 카카오톡 친구탭, 결국 12월 롤백… “격자형 피드는 선택 옵션으로”](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5517_10550_1119_1763853080_120.jpg)

![[테크 칼럼] 제미나이3, GPT-5.1을 넘다…AI는 이제 ‘일을 대신하는 시대’로 간다](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5457_10454_4847_1763621329_120.jpg)

![[낭만 테크 시대] AI 대항해 시대](https://cdn.kmjournal.net/news/thumbnail/custom/20251126/5603_10714_4334_1764121414_160.jpg)